【英文长推】为什么 AI 模型训练如此昂贵?

当前训练成本 - 数据 过去十年,训练计算的使用量每年增长 4 倍。根据 @EpochAIResearch 的数据,这一增长速度超过了一些历史上最快的技术扩张,包括手机采用的高峰增长率、太阳能装机容量的安装和人类基因组测序。 前沿模型训练运行的平均美元成本几乎同样迅猛 —— 在这一时期几乎每年增长 3 倍。 当今前沿模型的训练成本超过 1 亿美元。@OpenAI 今年在训练上花费超过 30 亿美元。@AnthropicAI 预测不久的将来将会有 100 亿美元的训练支出。 这一趋势没有减缓的迹象。在 Meta 的第二季度财报电话会议上,扎克伯格表示,他们计划在 Llama 4 上使用的计算量是 Llama 3 的 10 倍,这意味着大约 160,000 个 H100。 他表示未来的模型将会超过这一数量。其他实验室也在计划建设 100,000 个以上的 GPU 集群,有些(如 @xai 的)已经完成。 受益最大的主要是超大规模云服务提供商,以及英伟达,其数据中心收入在过去四年增长了 20 倍。 大实验室以外的研究人员无法获得足够的计算能力来有效地扩大他们的实验。这限制了他们在前沿研究中的贡献,从而限制了我们的创新速度。总体而言,训练是电力消耗密集型的。AI 服务器的电力消耗大约是普通云 CPU 服务器的 10 倍。日益上升的准入门槛导致竞争减少。我们现在看到的是,成本上升推动了行业内的整合。即使是资金充足的初创公司也被大型企业吞并(例如 Character、Inflection、Adapt)。这种现象在任何行业中都是不好的,但在 AI 领域尤其令人担忧,因为我们在日常生活中对 AI 的依赖日益加深。【原文为英文】\n原文链接

温馨提示:

快链头条登载此文本着传递更多信息的缘由,并不代表赞同其观点或证实其描述。

文章内容仅供参考,不构成投资建议。投资者据此操作,风险自担。

提示:投资有风险,入市须谨慎。本资讯不作为投资理财建议。

7*24小时快讯

热门资讯

熊市生存指南:L2 还有哪些潜在空投机会?

2022-05-13 12:47

目前的市场环境能否支撑比特币再次走牛?

2022-04-19 18:10

除了Coinlist,你还应该知道的打新平台

2022-03-01 13:37

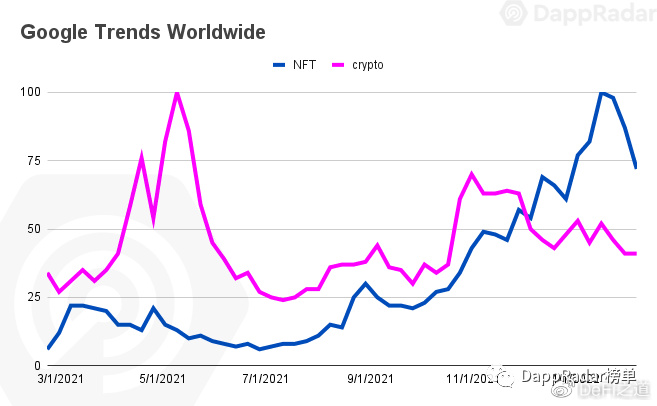

鲸鱼报告:解密知名NFT收藏家的交易模式

2022-02-28 16:56

最新活动

Solana Breakpoint 2025

2025-12-11 08:00

TOKEN2049 Dubai 2025

2025-04-30 08:00

2025 香港 Web3 嘉年华

2025-04-06 08:00

Consensus Hong Kong

2025-02-18 08:00